डीपफ़ेकः सावधान हो जाइये!

जिस एआई (Artificial intelligence) के बारे में कहा जा रहा है कि ये लोगों की ज़िंदगी को आसान बनाएगी वो एआई लोगों की ज़िंदगी को नरक बना सकती है। 6 नवंबर को एक्ट्रेस रश्मिका मंदाना का एक डीपफ़ेक वीडियो सोशल मीडिया पर वायरल हुआ। इस घटना को एक दिन भी नहीं बीता कि एक्ट्रेस कटरीना कैफ का डीपफ़ेक फोटो सोशल मीडिया पर वायरल हो गया। लेकिन ये सिर्फ एक-दो फोटो वीडियो का मामला नहीं है बल्कि इंटरनेट अभिनेत्रियों के डीपफ़ेक वीडियो से भरा पड़ा है।

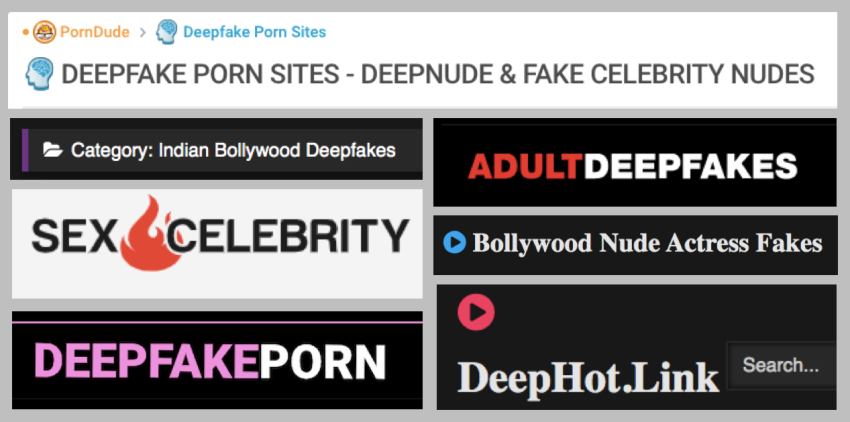

देसीफ़ेक डोट कोम, डीपफ़ेक पोर्न ड्यूड डॉट कोम, मिस्टर डीपफ़ेक, सी फ़ेक, अडल्ट डीपफ़ेक, सैक्स सेलेब्रेटी फ़ेक, डीपफ़ेक पोर्न, रियल डीपफ़ेक, इस तरह की सैकड़ों वेबसाइट पर सेलेब्रेटी के डीपफ़ेक पोर्न वीडियो भरे पड़े हैं। डीपफ़ेक वीडियो/फोटो में बड़ी तादाद पोर्न की है। डीपट्रेस की एक स्टडी के अनुसार डीपफ़ेक वीडियो में 96% पोर्न वीडियो हैं।

अब सवाल ये उठता है कि क्या फिल्मों में काम करने वाली लड़कियों की कोई प्राइवेसी और मानवीय गरिमा नहीं है। क्योंकि वो फ़िल्मों में काम करती हैं, तो उनके फोटो, वीडियो के साथ कुछ भी किया जा सकता है? उनके फ़ेक अश्लील वीडियो और फोटो इंटरनेट पर डाले जा सकते हैं?

अगर आप सोच रहे हैं कि ये सिर्फ हीरोइनों तक ही सीमित हैं, तो आप गलत सोच रहे हैं। डीपफ़ेक वीडियो का ये काला कारोबार महिला खिलाड़ियों, महिला राजनेता, इंस्टाग्राम इंफलुएंसर, यूट्यूबर, एक्टिविस्ट, पत्रकारों आदि तक पैर पसार चुका है। ये कभी भी आपके दरवाज़े पर दस्तक दे सकता है।

डीपफ़ेक की ट्रेनिंग शुरू हो चुकी है

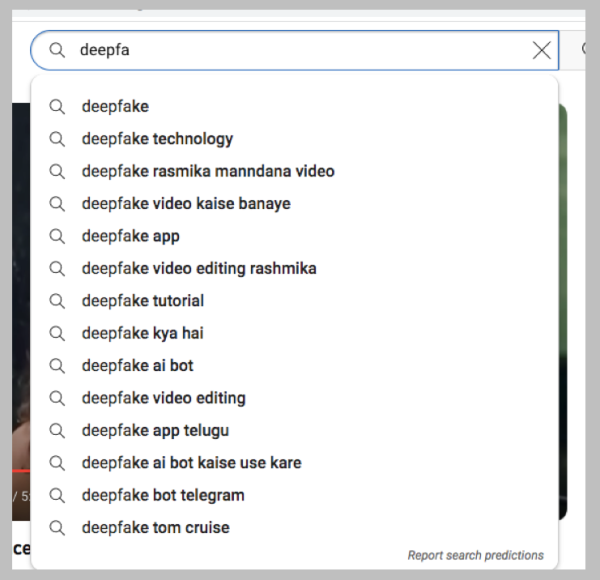

रश्मिका के इस डीपफ़ेक वीडियो को खतरे की घंटी समझिये। आप यूट्यूब सर्च बार में डीपफ़ेक टाइप करेंगे तो सजेशन आएंगे। डीपफ़ेक टेक्नोलोज़ी, डीपफ़ेक वीडियो कैसे बनाएं, डीपफ़ेक एप, डीपफ़ेक टुटोरियल, डीपफ़ेक वीडियो एडिटिंग, डीपफ़ेक एआई बोट, हाऊ टू डीपफ़ेक। यानी यूट्यूब पर भारी संख्या में लोग ऐसे वीडियो की खोज रहे हैं जो डीपफ़ेक वीडियो बनाना सिखा पाएं। डीपफ़ेक वीडियो बनाने की ट्रेनिंग शुरू हो चुकी है। अभी तक डीपफ़ेक के मामले विदेशों तक ही सीमित थे। लेकिन रश्मिका के डीपफ़ेक वीडियो ने भारत में भी इसके दरवाजे खोल दिए हैं। मेरा अनुमान है कि भविष्य में इस तरह के मामलों में बढ़ोतरी होगी और इसके दायरे में साधारण लड़कियां भी आ सकती हैं।

मैं ऐसा इसलिए कह रहा हूं क्योंकि ये सोफिस्टिकेटेड तकनीक अब आसानी से हर किसी को उपलब्ध है और ये बिल्कुल फ्री है। बस आपके पास स्मार्टफोन और इंटरनेट होना चाहिए। आपको बस किसी का फोटो या वीडियो इस एप पर अपलोड करना है, उसके बाद सारा काम एआई कर देगी। इस एडिटेड वीडियो को डाउनलोड करके, सोशल मीडिया पर शेयर कर सकते हैं। आज से कुछ साल पहले तक पहले इस तरह का सोफस्टिकेटेड फ़ेक वीडियो बनाना होता था तो बहुत मेहनत लगती और फिर भी इस तरह के वीडियो नहीं बन पाते। लेकिन आज ये काम चुटकियों में हो रहा है।

न्यूड डीपफ़ेक बनाना इतना सुलभ क्यों?

ऐसी बहुत सारी वेबसाइट और एप हैं, जहां आसानी से किसी भी वीडियो पर किसी का भी चेहरा लगाया जा सकता है। दो अलग-अलग लोगों की अलग-अलग फोटो को एक साथ लगाया जा सकता है। आपको लगेगा कि ये दोनो एकसाथ हैं। ये एप बैकग्राउंड को सिंक्रोनाइज कर देती हैं और ब्लैक एंड व्हाइट फोटो को कलर बनाकर, कलर फोटो के साथ जोड़ सकती है। आपके लिए पहचान पाना मुश्किल हो जाएगा कि ये अलग-अलग जगह की फोटो है और दोनों व्यक्ति साथ नहीं थे।

आर्टिफिशियल इंटेलिजेंस यानी एआई की मदद से इस तरह की वीडियो आसानी से तैयार की जा सकती है। इंटरनेट पर ऐसी सैकड़ों फ्री एप और सॉफ्टवेयर मौजूद हैं जो एक क्लिक पर किसी भी तस्वीर पर किसी का भी चेहरा लगा सकते हैं। किसी वीडियो पर आपका चेहरा लगा सकते हैं। आपकी आवाज़ को कॉपी किया जा सकता है और आपसे कुछ भी बुलवाया जा सकता है। वीडियो भी आपका होगा और आवाज़ भी हूबहू आपकी होगी। आर्टिफिशियल इंटेलिजेंसी और सीजीआई यानी कंप्यूटर जेनरेटेड इमेज़ के जरिये ये सब संभव है। इन तमाम बातों से स्पष्ट है कि हमें सावधान हो जाना चाहिए। इस तकनीक का मिसयूज़ किया जा सकता है, किया जा रहा है। आपको जागरूक होना ही पड़ेगा।

इस तरह की काफी वेबसाइट है जो किसी की भी फोटो से उसके कपड़े उतार सकती हैं। यानी आप किसी का भी न्यूड फोटो बना सकते हैं और वो भी बिल्कुल फ्री। इस तरह की भी वेबसाइट हैं जिनपर किसी का भी फोटो अपलोड करके ड्राइंग टूल के जरिये उसके कपड़े हटाये सकते हैं। इन वेबसाइट के होमपेज़ पर लिखा होता है, undress any photo with AI for FREE.

डिपफ़ेक के ख़तरे

आप समझ गये होंगे कि कितनी आसानी से ये काम किया जा सकता है। इसके परिणाम भयानक हो सकते हैं। इनका इस्तेमाल ब्लैकमेलिंग के लिए किया जा सकता है, किसी को बदनाम करने और उनके चरित्रहनन के लिए किया जा सकता है। मानसिक उत्पीड़न के लिए इसका इस्तेमाल किया जा सकता है। इस तरह के मामले किसी को डिप्रेशन से लेकर हत्या और आत्महत्या तक धकेल सकते हैं। सच को झूठ और झूठ को सच बनकर पेश कर सकते हैं।

आपको याद होगा जंतर-मंतर पर यौन उत्पीड़न के खिलाफ धरना दे रही महिला पहलवानों को जब पुलिस ने गिरफ्तार किया तो एक तस्वीर सोशल मडिया पर वायरल की गई थी। जिसमें ये महिला पहलवान हंस रही थी। ये फोटो फ़ेक था। असल में एक एप के जरिये ओरिजनल फोटो को एडिट किया गया था और इनके चेहरे के एक्सप्रेशन बदल दिए गए थे। आजकल कुछ फोन में इस तरह के फिल्टर इनबिल्ड आने लगे हैं। यानी आपको किसी थर्ड पार्टी एप की भी जरूरत नहीं है।

इस तरह के फ़ेक फोटो और वीडियो मात्र सच को झूठ और झूठ को सच ही नहीं बना देते हैं बल्कि लॉ एंड ऑर्डर की स्थिति पैदा कर सकते हैं, दंगे भड़का सकते हैं, हेल्थ इमरजेंसी पैदा कर सकते हैं, लोकतंत्र को कमज़ोर कर सकते हैं, किसी की इमेज़ खराब कर सकते हैं, यहां तक कि देश की सुरक्षा के लिए भी ख़तरा बन सकते हैं। सोचकर देखिये अगर युद्ध या बॉर्डर टेंशन के समय अगर देश के सबसे बड़े नेता या फौज के सबसे बड़े अफसर का कोई डिमोरलाइज़ करने वाला डीपफ़ेक वीडियो वायरल कर दिया जाए तो क्या होगा। एक डीपफ़ेक वीडियो युद्ध का पासा बदल सकता है। रूस-यूक्रेन युद्ध के दौरान ऐसी घटना हो चुकी है।

यूक्रेन के राष्ट्रपति का डीपफ़ेक वीडियो वायरल किया गया जिसमें वो यूक्रेनी सैनिकों को कह रहे थे कि हथियार डाल दो और रूस के सामने सरेंडर कर दो। बाद में प्रेज़िडेंट ज़ेलेंस्की ने वीडियो बनाकर इसका खंडन किया और बताया कि उनका डीपफ़ेक वीडियो वायरल किया जा रहा है उसे सही ना माने वो फ़ेक है।

एआई का इस्तेमाल करके आपको लाखों का चूना लगाया जा सकता है। एआई की मदद से यूके की कंपनी के सीईओ को एक कॉल आई। सीईओ को लग रहा था कि वो अपने बॉस से बात कर रहा है। लेकिन उसके पीछे स्कैमर थे जो एआई की मदद से उसके बॉस की आवाज़ में बात कर रहे थे। सीईओ को उसके बॉस ने कहा कि तुरंत 2,43,000 डॉलर फलां अकाउंट में ट्रांसफर करो और सीईओ ने कर दिया। सीईओ को रत्ति भर भी शक नहीं हुआ कि दूसरी तरफ उसके बॉस नहीं बल्कि स्कैमर हैं।

इसमें कोई दोराय नहीं कि डीपफ़ेक के ख़तरे बहुत हैं, लेकिन इनसे घबराने की ज़रूरत नहीं है। बल्कि आपको इन्हें समझने, जागरूक और सावधान होने की जरूरत है।

डीपफ़ेक कैसे पहचानें?

- अगर आपके पास ऐसा कोई वीडियो आता है तो उसे फ्रेम बाई फ्रेम गौर से देखिये।

- वीडियो में बालों पर गौर करें। क्या बाल कुछ अजीब लग रहे हैं।

- दांतों पर खासतौर पर गौर करें क्या दांत आपको असली लग रहे हैं या इनका पैटर्न और बनावट कुछ असामान्य है।

- अगर कोई ज्वैलरी वगैरह पहन रखी है तो उस पर गौर करें। देखें कि क्या उसमें जरूरत से ज्यादा चमक है।

- आंखों को ध्यान से देखें। क्या पुतलियां असामान्य लग रही है। वीडियो में देखें कि क्या पलक झपकने का पैटर्न बनावटी है।

- बोलते हुए होंठों की मूवमेंट ध्यान से देखें। क्या उसमें स्वाभाविक फ्लो है। या होंठो और उसके आस-पास की मांसपेशियां रोबोटिक ढंग से हिल रही है।

- स्किन के रंग पर ध्यान दें। क्या स्किन कलर में कंसिस्टेंसी है या कहीं पे कैसा और कहीं पे कैसा है?

- आस-पास के माहौल में कैसी रोशनी है, इस पर गौर करें। क्या वीडियो में व्यक्ति में जिस तरह की लाइट है और बैकग्राउंड में जिस तरह की लाइट है, उसमें कोई अंतर है? कुछ अजीब है।

अगर आप ऐसा करके भी नहीं पहचान पा रहे हैं कि वीडियो ओरिजनल है या डीपफ़ेक है। लेकिन आपको शक है कि इस वीडियो में कोई तो गड़बड़ है, तो इसे आगे फारवर्ड ना करें। गूगल पर वीडियो के बारे में सर्च करें और देखें कि क्या इस वीडियो का फैक्ट-चेक किया गया है। अगर आपको फैक्ट चेक नहीं मिलता है तो फैक्ट चेक वेबसाइट को ये वीडियो भेजें और उन्हें फ़ैक्ट चेक करने की रिक्वेस्ट करें। ऑल्ट न्यूज़ और बूम लाइव फैक्ट चेक वेबसाइट हैं। जिनको आप ये फोटो या वीडियो भेज सकते हैं। इनके नंबर इस प्रकार हैं -ऑल्ट न्यूज़- +917600011160, बूम लाइव- +91 77009-06111, +91 77009-06588

(लेखक स्वतंत्र पत्रकार एवं ट्रेनर हैं। आप सरकारी योजनाओं से संबंधित दावों और वायरल संदेशों की पड़ताल भी करते हैं। विचार व्यक्तिगत हैं।)

इन्हें भी पढ़ें :

भाजपा का प्रचारः पोस्टर एक, फ़र्ज़ी फ़ोटो चार

मोदी सरकार द्वारा जातिवार जनगणना के आंकड़े सार्वजनिक न करने की वजह?

अपने टेलीग्राम ऐप पर जनवादी नज़रिये से ताज़ा ख़बरें, समसामयिक मामलों की चर्चा और विश्लेषण, प्रतिरोध, आंदोलन और अन्य विश्लेषणात्मक वीडियो प्राप्त करें। न्यूज़क्लिक के टेलीग्राम चैनल की सदस्यता लें और हमारी वेबसाइट पर प्रकाशित हर न्यूज़ स्टोरी का रीयल-टाइम अपडेट प्राप्त करें।